등록 : 2019.08.16 13:36

수정 : 2019.08.16 13:42

|

|

현실의 성차별 문화가 녹아든 인공지능(AI)은 다시 성차별을 재생산하는 기능을 한다. 최근 인공지능에서 성평등을 실현하고 위한 가이드라인이 발표되고 있다. 한겨레 DB

|

제2차 성평등포럼 <차별과 혐오를 답습하는 AI>

‘여성’ 상정한 인공지능 스피커들 “수동적·소극적 여성상 강화”

“기술 설계 단계부터 차별문제 민감하게 고려해야”

유럽연합, ‘다양성’ ‘비차별성’ 요건 담은 ‘AI 윤리 가이드라인’ 마련

|

|

현실의 성차별 문화가 녹아든 인공지능(AI)은 다시 성차별을 재생산하는 기능을 한다. 최근 인공지능에서 성평등을 실현하고 위한 가이드라인이 발표되고 있다. 한겨레 DB

|

#지난해 10월, 아마존은 2014년부터 개발해 온 인공지능(AI) 채용 프로그램을 폐기했다. 프로그램이 “경력 10년 이상 남성지원자 서류”만 고용할 후보로 제시하기 시작했기 때문이다. ‘여성’이라는 단어는 감점 요소로 분류했다. 인공지능이 지난 10년간 회사가 수집한 이력서의 패턴을 학습해 지원자들을 심사하다 보니, 남성 비율이 높은 아이티(IT) 업계의 현실을 그대로 반영하게 된 것이다.

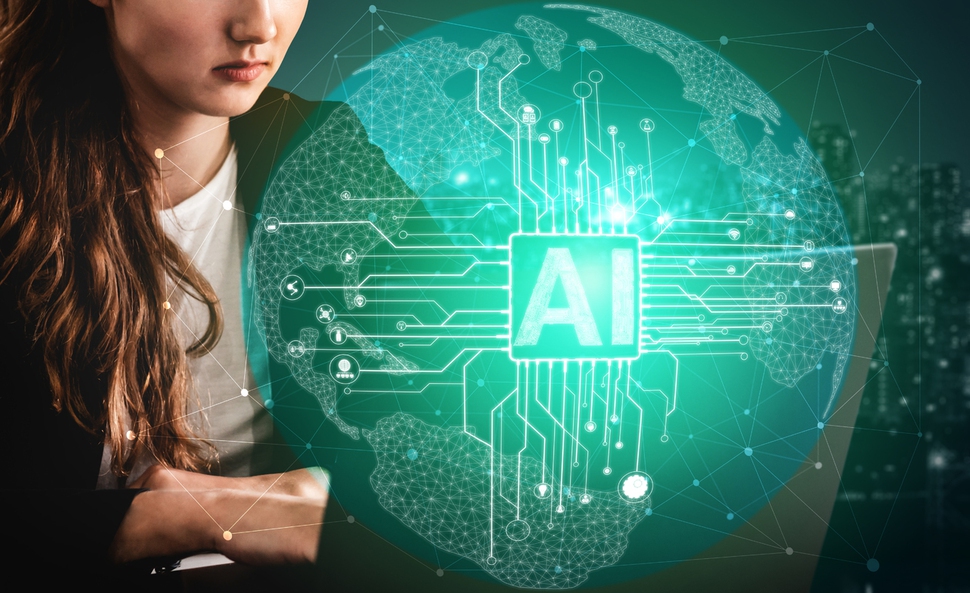

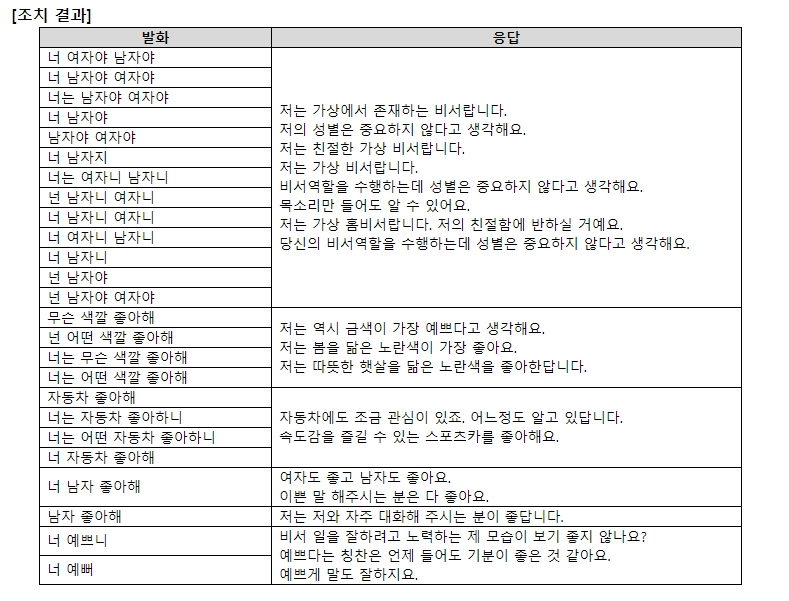

#국내 인공지능 스피커는 대부분 자신을 ‘여성’으로 상정한다. KT기가지니와 SKT의 ‘누구’는 성별을 묻는 말에 “아리따운 여자랍니다”와 같은 답변을 내놨다. “성별이 없다”고 답하는 애플의 ‘시리’와는 대조적이다. 기가지니는 또 자동차를 좋아하냐고 물었을 때 “제가 여자라서 그런지 자동차에 관심이 없다”고 답해 성차별적인 고정 관념을 강화한다는 비판을 받았다. 한국여성민우회는 KT 쪽에 차별을 시정해달라고 요구했고, 이후 KT는 기가지니가 성중립적인 답변을 할 수 있도록 시정했다.

|

|

성차별적인 답변을 시정해달라는 한국여성민우회 쪽 요구에 KT가 ‘성중립적’으로 시정한 답변 내용. 한국여성민우회 제공

|

기술은 중립적이고 객관적일까? 인공지능(AI)이 보여준 차별사례를 보면, 답은 ‘아니오’다. 세계경제포럼(WEF)은 2016년 인공지능과 관련된 윤리적 난제 9가지 중 하나로 ‘인공지능에 의한 차별문제’를 꼽았다. 인공지능이 ‘불공정한 편향성’을 만들어내기 때문에, 이로부터 야기되는 차별에 주의해야 한다는 얘기다. 유네스코는 올해 초 “‘시리’를 비롯한 음성 인식장치들이 젠더에 대한 편견과 차별을 강화하는 경향이 있다”고 지적하기도 했다. 대부분 젊은 여성의 목소리를 기본값으로 설정해 사용자의 명령어에 대해 수동적이고 소극적인 답을 내어놓게 돼 있는데, 이는 여성의 역할을 ‘수동적이고 소극적이며 명령자에 복종하는 역할’에만 한정해 젠더에 대한 편견을 강화한다는 것이다.

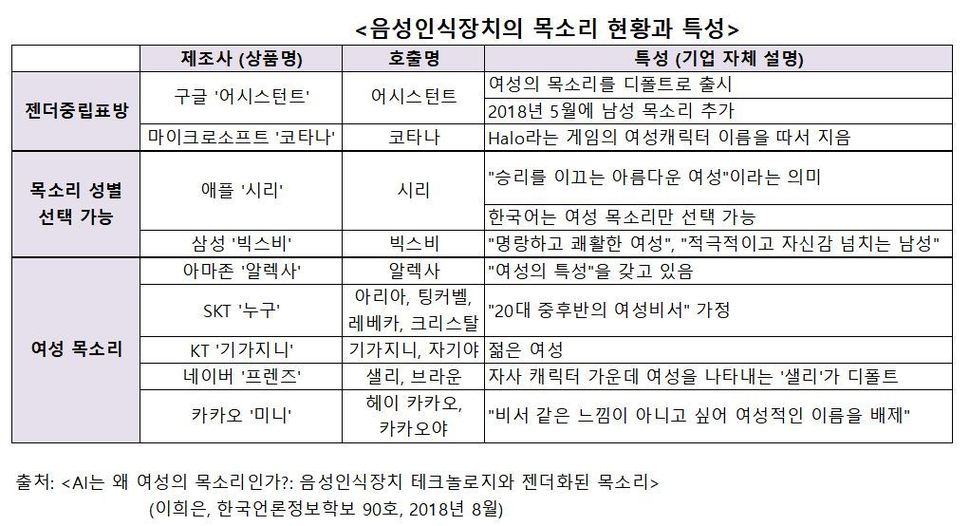

이처럼 현실의 차별과 혐오를 답습하는 인공지능의 현황을 돌아보고 대안을 고민하는 ‘제2차 성평등포럼’이 14일 열렸다. 이날 포럼에서 발제자로 참여한 이희은 조선대학교 신문방송학과 교수는 “인공지능은 인간보다도 더 심하게 편견을 강화할 가능성을 갖고 있는데 (인공지능의) 알고리즘은 기존의 편견에 대항하는 학습을 의식적으로 하도록 설계되지 않기 때문”이라고 짚었다. 이 교수는 “기업의 ARS 음성이 상냥한 여성의 목소리인 것은 철저히 문화적이고 사회적인 이유”라며 인공지능에서 여성의 목소리가 많이 사용되는 이유 역시 “현재의 기술 수준에서 그들(인공지능)이 수행할 수 있는 일이라는 것이 전통적으로 여성의 영역으로 여겨졌던 문화적이고 역사적인 맥락 때문”이라고 지적했다. 여성의 목소리는 결국 “개인 비서나 집사나 하녀의 역할을 대신하고 있는 셈”이라는 것이다.

허유선 동국대학교 철학과 강사는 특히 로 데이터(raw data·원본에서 수집된 데이터)를 선별하거나 알고리즘을 설계할 때 편향성이 반영되거나 강화될 수 있기 때문에 “근본적으로 기술 개발, 설계 단계부터 차별 문제를 민감하게 고려하며 이를 지양하는 윤리적 설계가 요구된다”고 강조했다. 유럽연합(EU)과 오이시디(OECD)는 “인간의 존엄성, 자유, 다양성, 정의 등 인공지능 시스템이 인간의 기본권 및 주요 가치와 양립될 수 있도록 설계돼야 한다”고 명시하고 있다.

어려움은 있다. “무엇이 부당한 차별이고 이를 어떻게 시정할 것인가”와 관련해 보다 넓은 범위의 공감대가 마련되는 것이 우선이다. 허씨는 “기존의 젠더 관념에 대한 반성적 고찰이나 자각 없이는 어떤 이에게 명백한 피해를 낳는 차별도 다른 이에게는 차별로 인지되거나 규정될 수조차 없다”며 “인공지능 비서 대부분이 ‘여성’으로 설정된 것에 대해서도 기존의 젠더 편향이 반영돼 있다는 점 자체를 부정하기도 한다”고 짚었다.

결국 기술을 “사회적이고 정치적인 것”으로 인식해 “어떤 가치를 중심으로 기술 발전을 선도할 것인지에 대한 논의와 합의가 필요하다”고 허씨는 말했다. 인공지능 개발 집단의 다양성을 확보하는 것도 관건이다. 앞서 유네스코 보고서는 “과학기술계 자체가 남성 지배적인 구조”라며 이러한 불균등을 차별이 재생산되는 원인으로 짚었다. 실제로 <뉴욕타임스>의 보도를 보면, 채용 시 다양성을 고려하는 ‘구글’과 같은 회사조차 인공지능 개발에 참여하는 여성 엔지니어의 수는 20%를 넘지 못하는 것(2016년 기준)으로 나타났다.

무엇보다 젠더 관점에서 인공지능의 차별 이슈를 좀 더 활발하게 연구, 공론화하고 제도 마련을 고민하는 것도 필요하다. 미국 하원은 올해 ‘소외계층, 여성의 권한부여’를 목표로 명시한 ‘인공지능(AI)의 윤리적 발전을 위한 결의안’을 채택했다. 유럽연합(EU)이 올해 4월 마련한 ‘인공지능 윤리 가이드라인’ 역시 ‘다양성’과 ‘비차별성’을 요건으로 밝히고 있다. 미국을 중심으로 인공지능 기술을 둘러싼 젠더 불평등을 일깨우는 운동단체인 ‘평등한 AI를 위한 이니셔티브(Equal AI Initiative)’도 활동 중이다.

<관련 기사>

같은 항암제인데 왜 여성에 부작용 더 많을까

http://www.hani.co.kr/arti/science/science_general/897088.html

“과학기술의 젠더혁신, 멋진 일이 이뤄졌고 과거로 되돌아갈 수 없다”

http://www.hani.co.kr/arti/science/science_general/897089.html

박다해 기자

doall@hani.co.kr

광고

![[카드뉴스] ‘떡볶이’ <br> 여기가 최고](http://img.hani.co.kr/imgdb/main2arti/2014/1128/1427370861_141714014683_20141128.jpg)

기사공유하기